Entre plataformas digitales, inteligencia artificial y datos invisibles, una nueva forma de poder emerge: la influencia silenciosa de los algoritmos. Este texto explora cómo la automatización y los flujos de información están transformando el debate público, el consumo de noticias y la democracia misma.

En un mundo cada vez más interconectado y digitalizado, los algoritmos no solo recomiendan series y productos, sino que también influyen silenciosamente en nuestras ideas, decisiones y percepciones políticas. Este reportaje explora cómo la inteligencia artificial, el big data y las redes sociales están transformando el espacio público, la democracia y la forma en que nos relacionamos con la información. Basado en una rigurosa investigación académica, revelamos los riesgos, implicaciones y tensiones que surgen cuando el juicio humano es desplazado por la lógica automatizada.

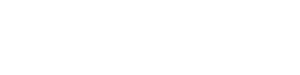

Imagine por un momento que cada vez que entra a una red social, cada noticia, meme o publicación que ve no está ahí por casualidad, sino por una fórmula matemática que ha aprendido de sus clics, sus búsquedas y hasta de sus silencios. Esa fórmula tiene nombre: algoritmo, y está redefiniendo no solo lo que consumimos, sino lo que pensamos y creemos. En la actualidad, los algoritmos se han convertido en los nuevos mediadores de la esfera pública.

No solo organizan la información, sino que la jerarquizan y seleccionan lo que cada individuo verá en su pantalla, generando una experiencia profundamente personalizada. Pero esa personalización tiene un costo: la pérdida de una narrativa común y la fragmentación del espacio público.

Lo que comenzó como una solución técnica para gestionar la sobrecarga de información, hoy es un mecanismo que puede reforzar prejuicios, alimentar polarizaciones y, en última instancia, moldear la opinión pública. El reportaje que tiene en sus manos, basado en un riguroso análisis teórico, analiza cómo la inteligencia artificial, el big data y los sistemas algorítmicos están transformando el campo de la comunicación, el periodismo y la política.

Desde que el sociólogo alemán Jürgen Habermas propuso el concepto de esfera pública en el siglo XX, se entendió que existía un espacio en donde los ciudadanos deliberaban colectivamente sobre los asuntos comunes. Sin embargo, con el auge de las redes sociales y la tecnología digital, esa esfera se ha trasladado a plataformas gestionadas por grandes corporaciones como Meta (antes Facebook), Google y X (antes Twitter), donde lo que se ve y lo que no se ve depende del diseño opaco de sus algoritmos.

Esta situación ha generado una nueva forma de control que va más allá de la censura directa: se trata de la censura algorítmica. Este fenómeno consiste en filtrar, priorizar o invisibilizar información de manera automatizada, sin intervención humana directa, lo que plantea serias preocupaciones éticas sobre la libertad de información y el pluralismo democrático. El filósofo francés Pierre Lévy ya había advertido sobre la transformación de las lógicas de poder en la era de la información. En lugar de jerarquías visibles, los nuevos centros de poder son redes descentralizadas e invisibles que controlan el flujo de datos.

Créditos de la imagen: IMF

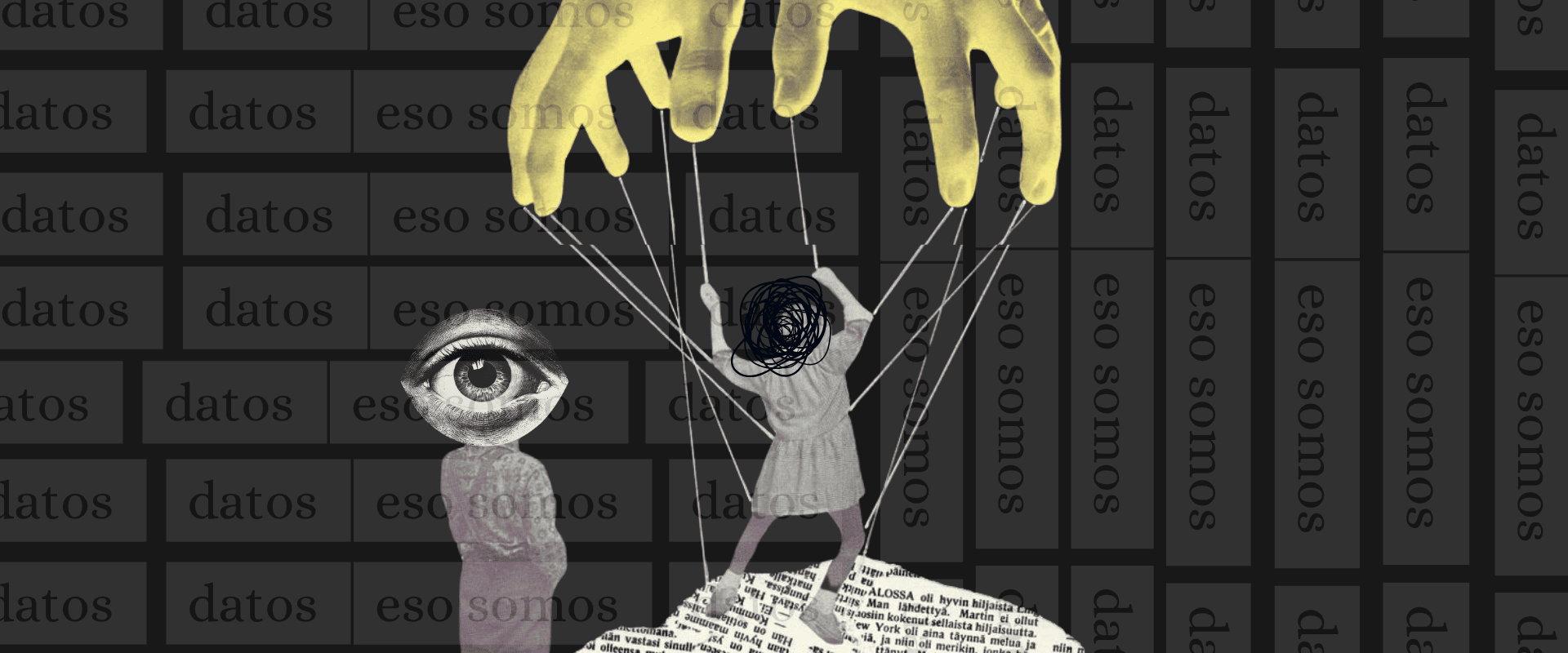

En este contexto, la “algoritmización” de la vida social implica una delegación creciente de decisiones humanas a sistemas automatizados, lo cual conlleva tanto eficiencias como riesgos inéditos. La idea de que los algoritmos son neutros ha sido ampliamente cuestionada. La investigadora Cathy O’Neil, en su libro “Weapons of Math Destruction”, señala que los algoritmos perpetúan desigualdades cuando se alimentan de datos históricos sesgados. Es decir, el pasado injusto se reproduce en las recomendaciones automatizadas, lo que refuerza estereotipos y patrones de exclusión.

En el campo del periodismo, esto se traduce en una lógica de visibilidad donde los contenidos más virales o polémicos son priorizados, dejando en la sombra a las voces críticas o a las noticias de interés público. Además, la personalización de la información puede encerrar a los usuarios en “cámaras de eco” digitales, donde solo se encuentran con opiniones similares a las suyas. Este fenómeno debilita el debate democrático y favorece la polarización. El algoritmo de Facebook, por ejemplo, ha sido señalado por priorizar contenidos que generan emociones fuertes, como el miedo o la indignación, ya que estos aumentan el tiempo de permanencia en la plataforma. Así, se favorecen las narrativas extremas en detrimento del consenso o la deliberación racional.

Créditos de la imagen: Derechos Digitales América Latina

En Colombia, el uso de herramientas de análisis de datos con fines políticos ha crecido significativamente. Durante las elecciones de 2018 y 2022, se documentó cómo las campañas utilizaron técnicas de microsegmentación para enviar mensajes personalizados a los votantes, basados en su comportamiento en redes. Esta estrategia, si bien eficaz en términos de marketing, plantea dilemas democráticos sobre la manipulación del electorado y la falta de transparencia en la circulación de información política.

La académica Shoshana Zuboff ha denominado a este nuevo modelo económico como “capitalismo de la vigilancia”. En este esquema, los datos personales son la materia prima con la cual las plataformas producen predicciones sobre nuestro comportamiento, que luego son comercializadas a terceros. Esto convierte al ciudadano no en el cliente, sino en el producto. La consecuencia es que nuestra privacidad se ve erosionada y nuestras decisiones comienzan a ser anticipadas —y moldeadas— por agentes que no podemos ver ni controlar.

Por otro lado, en el ámbito de la comunicación institucional y de marca, los algoritmos han redefinido las estrategias de alcance y posicionamiento. Las empresas invierten en “content performance” y SEO (optimización en motores de búsqueda) no solo para aparecer en los primeros lugares de Google, sino para adaptarse a los criterios invisibles que regulan la visibilidad. En consecuencia, se privilegia lo “clickable” sobre lo importante. Desde el punto de vista ético, surge la pregunta sobre el rol del periodista en este nuevo ecosistema. ¿Debe adaptarse a las reglas del algoritmo para sobrevivir o resistirse a ellas para defender la integridad de la información? En esta tensión se juega el futuro del oficio, que debe equilibrar la innovación tecnológica con el compromiso social.

La educación mediática cobra aquí un rol fundamental: los ciudadanos deben ser alfabetizados no solo en lectura crítica, sino en comprensión de los entornos digitales y sus implicaciones. En la academia, cada vez hay más voces que piden una regulación de los algoritmos, o al menos, una exigencia de transparencia. Organismos como la UNESCO y el Foro Económico Mundial han propuesto marcos éticos para el diseño de inteligencia artificial, que garanticen equidad, justicia y responsabilidad. No obstante, la implementación de estos marcos aún es incipiente y depende en gran medida de la voluntad política y de la presión social.

Créditos de la imagen: Junior Report

Al final, el debate no es solo técnico, sino profundamente político. Se trata de quién tiene el poder de decidir qué vemos, qué pensamos y cómo actuamos. En este sentido, los algoritmos no son solo herramientas, sino actores que participan activamente en la configuración del espacio público. Por eso, entender su lógica, sus limitaciones y sus sesgos no es solo una tarea para ingenieros, sino para todos los ciudadanos que creen en la democracia, la libertad y el derecho a decidir informadamente.

La invitación, entonces, es a no dejarse llevar por la comodidad del scroll infinito. A hacer pausas, a preguntar, a exigir transparencia. Porque detrás de cada publicación que aparece en nuestra pantalla hay una decisión -automatizada o no- que está moldeando nuestra visión del mundo. Y si no participamos en esa conversación, otros lo harán por nosotros.